Dual Render Fusionの概要

Dual Render Fusionは、Snapdragon Spaces for Unity SDKで使用できる拡張現実感(AR)の新しいコア機能で、同じAndroidのActivity内で、スマートフォンの画面と接続されたARグラスの両方に同時に描画できます。

また、Snapdragon Spacesで提供される完全な知覚機能とともに、スマートフォンのタッチスクリーン入力をフル機能で使用することができます。

Snapdragon Spaces SDKのバージョン0.23.0から、Dual Render Fusion機能がSDKの一部として含まれています。最新バージョンのDual Render Fusionを使い始めるには、セットアップガイドに従ってください。

アーキテクチャ情報と対応プラットフォームについては、Dual Render Fusion Architectureのページをご参照ください。

関連項目

「Headworn」と「Dual Render Fusion」の比較

Dual Render Capabilities

Dual Render Fusionは、スマートフォンをプライマリディスプレイとして扱い、ARグラス側をセカンダリディスプレイとして扱います。

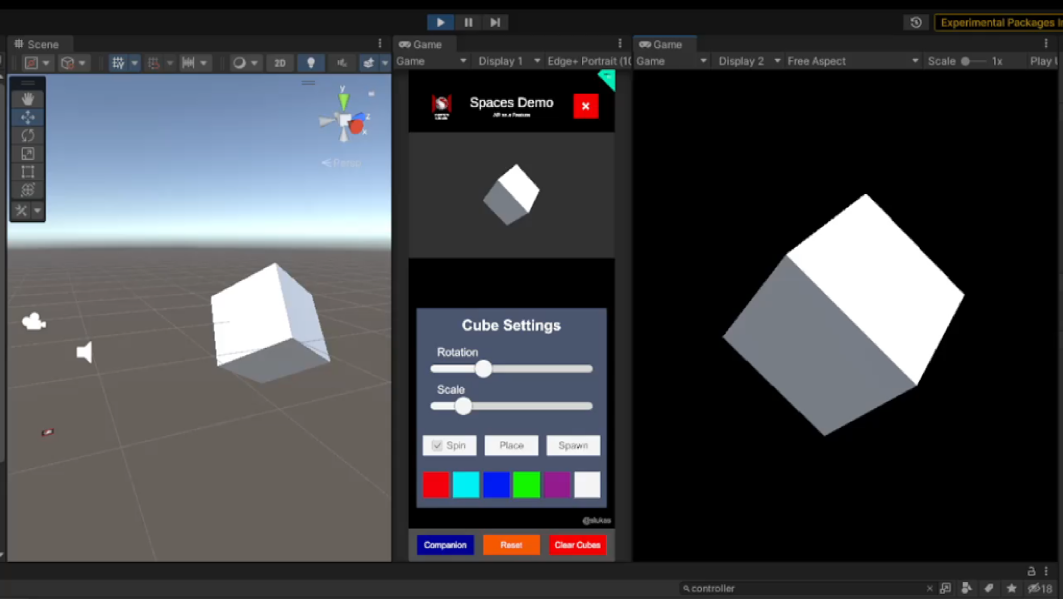

Unity Editor内ではARグラス側の映像はDisplay 2をターゲットにしていますが、実機上ではARグラス側の映像はDisplay 1をターゲットにしています。

このデュアルレンダリング機能は、新規または既存の2Dアプリを、コード不要で3DのARアプリに拡張することが出来ます。

2Dアプリに、ARディスプレイとして2つ目のゲーム内カメラが追加されるイメージです。

複数の入力方法

Dual Render Fusionは、Snapdragon Spaces SDKで利用可能な入力方法(ハンドトラッキング、スマホのポインター、視線ポインター)を利用できるのと同時に、一般的なアプリと同様にスマートフォンのタッチスクリーンを使用することが出来ます。

モバイルアプリの拡張

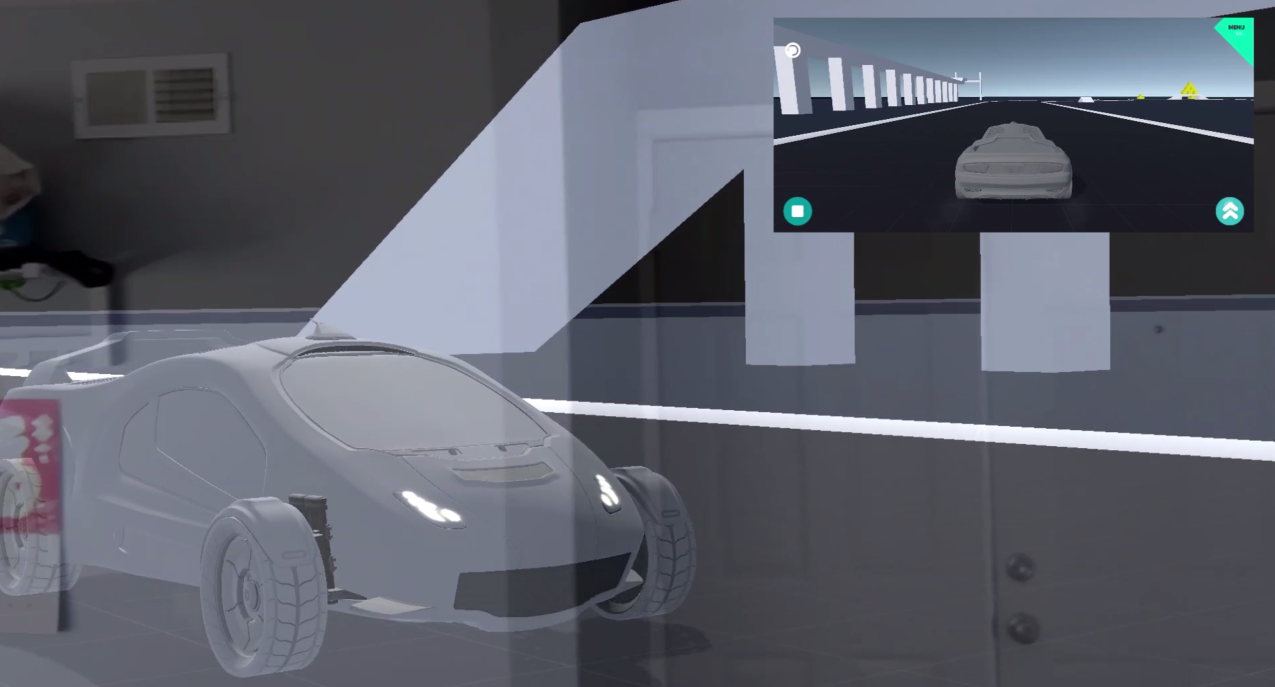

スマートフォンはタッチ操作と画面表示が可能であるため、ARオブジェクトを追加することは簡単になりました。

この組み合わせにより、既存のモバイルアプリを、使い慣れた操作性を維持しながら新しい没入感のあるAR上で体験ができるようになります。

つまり、既存のアプリをSnapdragon Spacesに移植することができます。

使用例

スマートフォンの機能が使える以上、Dual Render Fusionの使用例は無限にあります。以下はDual Render Fusionを利用することで、日常的な拡張現実がどのように見えるかの例です。

オンラインショッピング

タッチスクリーン入力を使えば、UIをスマートフォン向けに最適化できる一方、実寸大の家具や衣服などを選び、接続されたARグラスから直接見ることができます。

メディアの視聴

開発者は、タッチスクリーン入力機能を組み合わせて、スマートフォンでお気に入りの写真をスワイプしながら、ARグラスのハンドトラッキングを使い個々の写真を動かしたり拡大したりすることができます。

ゲーム

Dual Render Fusionにより、開発者はスマートフォンをモバイルゲームの完全なタッチスクリーンのコントローラーとして使用することができます。 さらに拡張現実(AR)によりアクションゲームを没入感のある映像として表示することができます。